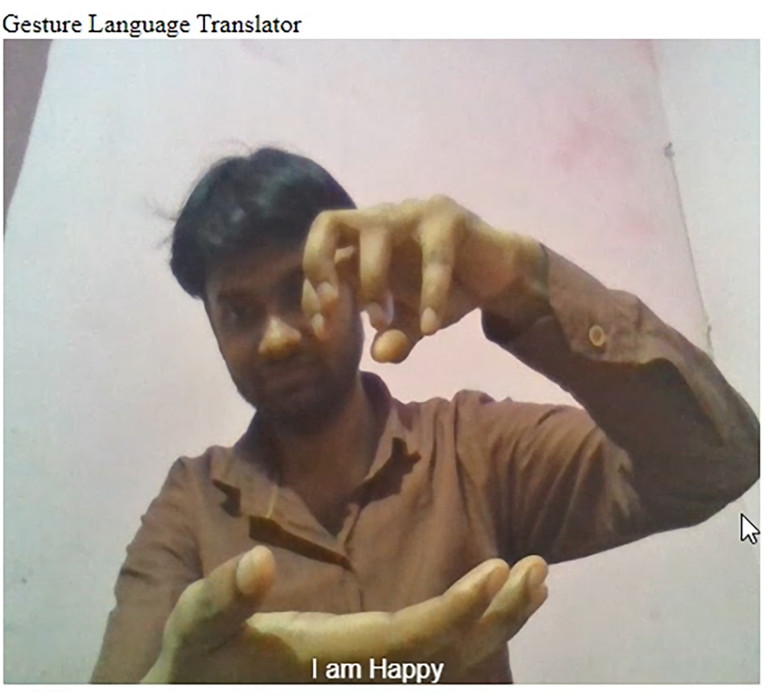

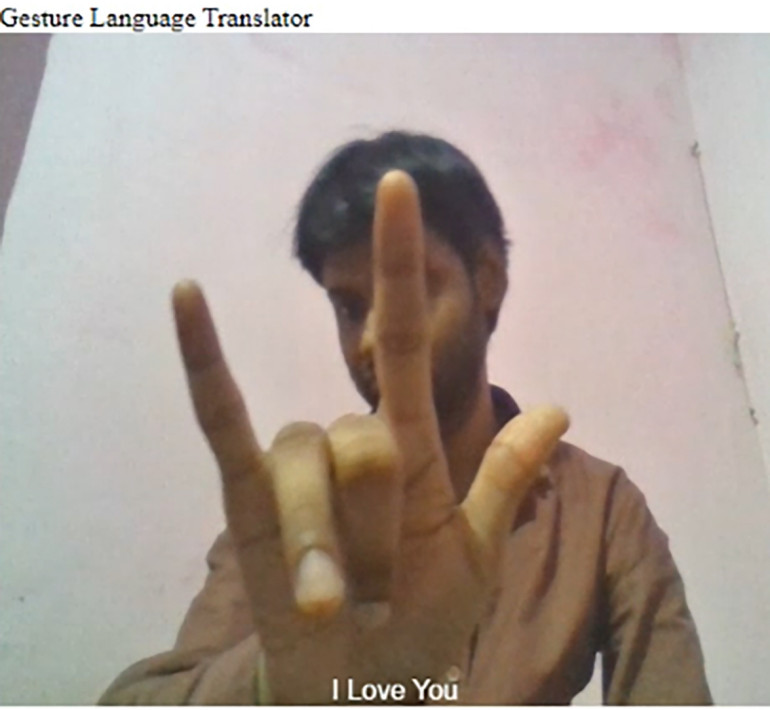

Żeby złagodzić ten problem, w artykule opisywane jest urządzenie Gesture Language Translator, które konwertuje język migowy na język mówiony. Urządzenie to będzie oparte na modelu ML, który może rozpoznać różne gesty języka migowego dla dokładnego tłumaczenia.

Przygotowanie modelu ML

Istnieją różne języki migowe praktykowane w różnych krajach. Na przykład, w Indiach używa się Indyjskiego Języka Migowego (ISL), podczas gdy w USA używa się Amerykańskiego Języka Migowego (ASL). Tak więc, najpierw musisz zdecydować, który typ chcesz zaimplementować.

Aby uzyskać zestawy danych ASL, odwiedź tę stronę. Dla ISL, odwiedź tę stronę. Możesz na nich znaleźć liczne gesty rąk, które są używane w życiu codziennym.

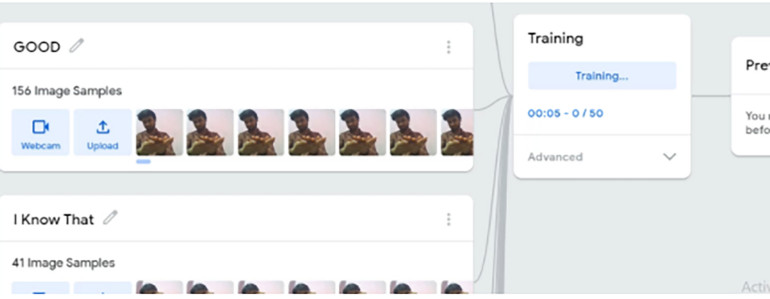

Po zebraniu zbiorów danych, przygotuj model ML do treningu. Istnieje wiele opcji do tego celu, takich jak TensorFlow, Keras, PyTorch, Google's Teachable Machine, itp. W tym projekcie używany jest Google's Teachable Machine, który jest usługą online do tworzenia modeli ML. W kolejnym kroku wprowadź zestawy danych do wybranego przez siebie kreatora modeli ML i uchwyć aparatem fotograficznym różne gesty/znaki dłoni. Pamiętaj, aby opisać je zgodnie z ich znaczeniem.

Wdrażanie modelu ML

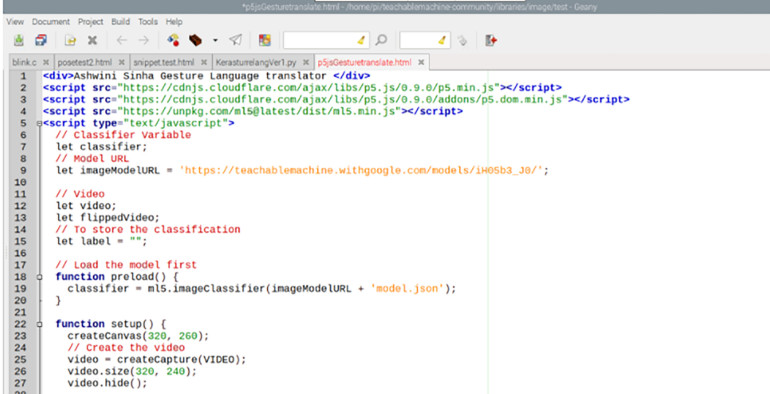

Po wykonaniu powyższych kroków, pobierz wynik działania modelu ML. Możesz też skorzystać z opcji wgrania modelu ML. Prześlij kod, a otrzymasz link do modelu ML i fragment kodu do wykorzystania w modelu ML, który może być użyty na różnych platformach, takich jak Python używając Keras P5.js lub JavaScript (JS). Po wgraniu modelu ML, skopiuj kod skryptu JS.

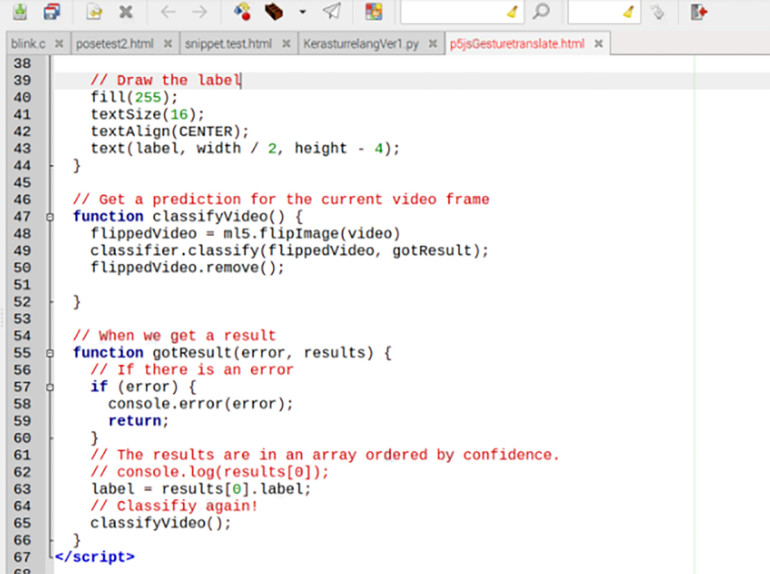

Kodowanie

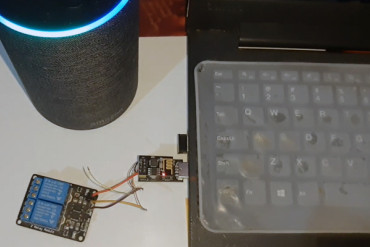

Otwórz pulpit Raspberry Pi, a następnie utwórz nowy plik JS. Poniżej pokazany jest plik Gesturetranslator.html. Wklej do niego fragment kodu i wpisz nazwę projektu. Zwiększ rozmiar obrazu z aparatu tak, aby był dobrze widoczny w większej przestrzeni. Zapisz go.

Testowanie

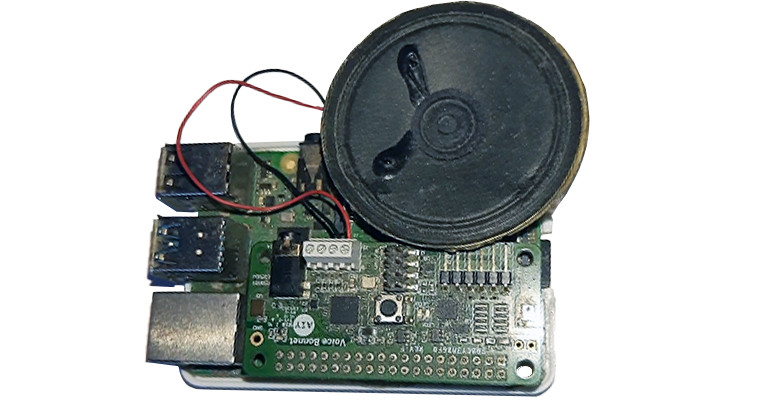

Najpierw należy włączyć interfejs aparatu w Raspberry Pi i podłączyć go do płytki. Następnie należy otworzyć kod JavaScript w Google Chrome lub innej przeglądarce, która obsługuje JS.