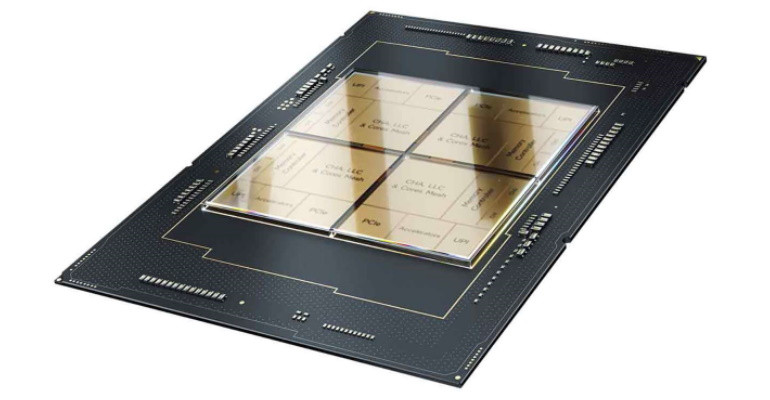

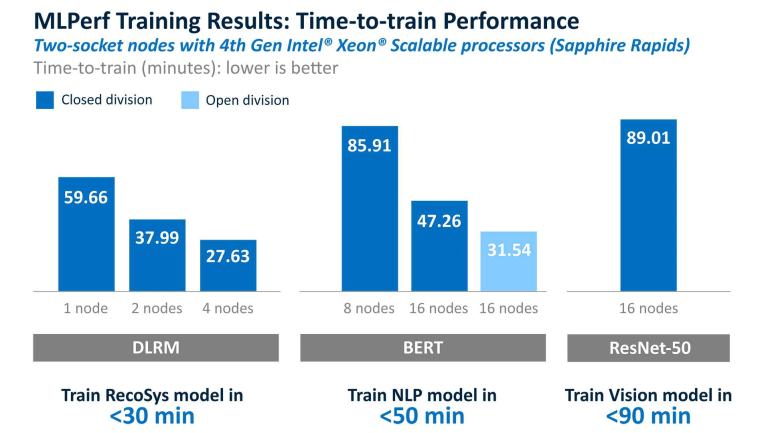

Zgodnie z wynikami MLPerf Training v2.1, trening modeli DL: DLRM, BERT oraz ResNet-50 na czwartej generacji procesorów Xeon Scalable zajmuje przynajmniej kolejno: 27,63 s, 31,54 s i 89,01 s. Na tej podstawie procesory umożliwiają wydajną implementację rozwiązań sztucznej inteligencji (AI). Rodzina procesorów Xeon Scalable znajduje użytek choćby w frameworkach. Deweloperzy sprzętowi mogą stosować 2 biblioteki: TensorFlow i PyTorch, które dedykowane są wspomnianej rodzinie. Mogą oni w szczególności nauczać modele DL w trakcie przerwy na kawę czy lunch. Procesory firmy Intel obsługują każde obciążenie związane z AI. Zapewniona jest ich całoroczna praca oraz niski koszt użytkowania.

Więcej informacji pod adresami: link 1 i link 2 oraz na poniższych materiałach.