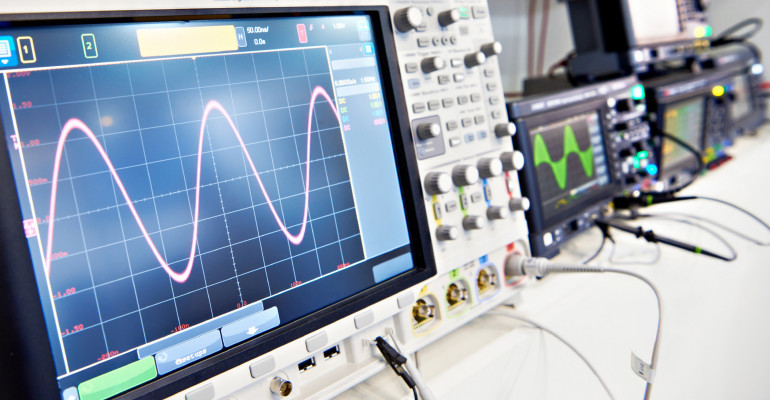

Drastyczny spadek cen komponentów elektronicznych – charakterystyczna cecha dynamicznego i wielokierunkowego rozwoju tej branży – jest widoczny także w segmencie aparatury pomiarowej. Ciągły wzrost wydajności procesorów aplikacyjnych, wprowadzanie na rynek coraz lepszych (szybszych, mniej „szumiących” i dokładniejszych) przetworników ADC, czy nawet upowszechnienie precyzyjnych źródeł częstotliwości wzorcowej o doskonałych parametrach fazowych i wysokiej stabilności – to tylko niektóre z czynników, które wpływają na ciągłe przeobrażenia w rynku przyrządów laboratoryjnych, a zwłaszcza oscyloskopów cyfrowych i analizatorów widma.

Jednak sama tylko dostępność komponentów to zdecydowanie nie wszystko – równie istotne są zmiany, które zachodzą w zakresie realnych potrzeb użytkowników. Superszybkie interfejsy cyfrowe – w tym przede wszystkim kolejne wersje standardu USB 3.x czy nawet USB 4 – wręcz wymuszają na producentach aparatury pomiarowej wdrażanie rozwiązań umożliwiających sprawne i wiarygodne debugowanie szeregowych łączy transmisyjnych. A jest o co walczyć – przecież niemal każdy współczesny telefon, nie wspominając już o komputerach, dyskach zewnętrznych, nośnikach typu pendrive czy nawet rozmaitych urządzeniach specjalistycznych – jest dzisiaj wyposażony w szybki port USB. Jeżeli w nowym projekcie pojawiają się problemy związane z integralnością sygnałów, objawiające się czy to całkowitą utratą transmisji, czy – co gorsza – trudniej uchwytnymi dysfunkcjami, widocznymi tylko w określonych warunkach testowych – to podłączenie szybkiego oscyloskopu z odpowiednimi sondami staje się absolutną koniecznością. A nowoczesne łącza bezprzewodowe? One też nierzadko wymagają „podejrzenia” rzeczywistych przebiegów i zmierzenia szeregu parametrów wpływających na bilans łącza czy niezawodność transmisji. To samo dotyczy radarów, które dawno przestały już być domeną branży wojskowej i weszły do stałego repertuaru technik sensorycznych w innych aplikacjach, chociażby w nowoczesnej motoryzacji czy w coraz szerszym sektorze małych satelitów.

Co jeszcze należy wziąć pod uwagę analizując trendy na rynku oscyloskopów? Spore znaczenie mają także przyzwyczajenia samych użytkowników. Chyba nikt nie ma już wątpliwości, że żyjemy w czasach „dotykowych” – coraz więcej urządzeń projektowanych i wprowadzanych na rynek nie ma już żadnych albo prawie żadnych elementów elektromechanicznych (przełączników, przycisków, enkoderów obrotowych), klasycznych potencjometrów itp. Producenci rezygnują z nich na rzecz coraz lepszych ekranów dotykowych, a trend ten jest dodatkowo napędzany przez intensywnie rozwijający się rynek „multimedialnych” procesorów aplikacyjnych, o których zresztą sporo piszemy w tym numerze „Elektroniki Praktycznej”. To wszystko sprawia, że większość nowych modeli oscyloskopów jest już wyposażona w spore ekrany dotykowe o doskonałej jakości obrazu, a interfejsy graficzne tegoż sprzętu już na etapie wstępnych założeń są projektowane z myślą o sterowaniu dotykowym. I to nie byle jakim, bo zwykle uwzględniającym rozmaite gesty, chociażby w zakresie przeskalowywania wzmocnienia kanałów wejściowych czy też podstawy czasu (funkcja multi-touch zawsze w cenie!).

Szybciej, łatwiej, lepiej

Wspomniany już wpływ rozwoju branży zaawansowanych systemów wbudowanych na funkcjonalność pomiarową i parametry oscyloskopów jest widoczny (siłą rzeczy) niemal wyłącznie w segmencie konstrukcji high-end. Najdroższe serie oscyloskopów są już dziś wyposażane w zautomatyzowane narzędzia programowe i sprzętowe umożliwiające np. prowadzenie testów zgodności badanego urządzenia (DUT) z wymogami standardu USB 4. Sprawa zdecydowanie nie jest banalna, gdyż w czwartej generacji USB mamy już do czynienia z potężną przepustowością (do 40 GB/s) oraz ogromem rozmaitych problemów wynikających z tak dużej prędkości transmisji – specyfikacja nowego łącza szeregowego określa m.in. wymagania dotyczące takich parametrów jak jitter czy szybkość narastania zboczy sygnału, a dodatkowo trzeba weryfikować wpływ wszystkich elementów linii transmisyjnej na przesłuchy, odporność na zakłócenia EMI i wiele innych aspektów. A przecież rynek komputerowy nie zatrzymuje się w dążeniu do „podkręcania” szybkości przesyłu danych – USB 4 2.0 to już 80 GB/s w trybie symetrycznym oraz 120 GB/s w asymetrycznym (!).

Podstawową reprezentacją jakości przesyłu danych szeregowych jest diagram oka, pozwalający szybko ocenić najważniejsze parametry integralności sygnałowej łącza. Specjalistyczne oprogramowanie współpracujące z najnowocześniejszymi oscyloskopami w dużej mierze automatyzuje cały proces pomiaru, tworząc rozbudowane raporty oraz klasyfikując DUT pod kątem (nie)spełnienia wymogów narzuconych przez specyfikację standardu USB. Warto w tym miejscu przypomnieć, że diagram oka nie jest po prostu zwykłym nałożeniem na siebie kolejnych przebiegów zmierzonych na cyfrowej szynie danych. W rzeczywistości bowiem do utworzenia takiego wykresu konieczne jest zaawansowane odzyskiwanie sygnału zegarowego (clock recovery), dzięki któremu oprogramowanie oscyloskopu jest w stanie utworzyć wiarygodną reprezentację „statystyczną” zboczy i stanów na linii (poprzez nałożenie na siebie oscylogramów zarejestrowanych dla kombinacji trzech kolejnych bitów: 000, 001, 010, 011, 100, 101, 110 oraz 111).

Aby nie być gołosłownym, przyjrzyjmy się naprawdę imponującym parametrom najwyższego modelu oscyloskopu z serii UXR, czyli jednego z najbardziej zaawansowanych urządzeń tego typu na świecie. Jako przykład przytoczymy tutaj wersję absolutnie topową, czyli UXR1104A:

- 4 kanały analogowe,

- pasmo pomiarowe: 110 GHz,

- próbkowanie: 256 GSa/s (w każdym kanale),

- pamięć próbek do 2 Gpts,

- rozdzielczość przetworników ADC: 10 bitów (natywna)/14 bitów (w trybie uśredniania),

- czas narastania/opadania: 44 ps,

- cena: około 6,8 mln PLN.