Kwestia zasilania ma kilka aspektów. Pierwsza kwestia: po co i dlaczego wprowadza się PoE? To akurat jest bardzo proste: w bardziej skomplikowanych sieciach ethernetowych pracuje wiele urządzeń, które musza być zasilane. Prowadzenie oddzielnych obwodów zasilania do każdego z wielu urządzeń, często oddalonych, jest kłopotliwe i kosztowne. Dużo prościej i taniej jest wykorzystać do zasilania kabel ethernetowy, który musi być doprowadzony do każdego takiego urządzenia.

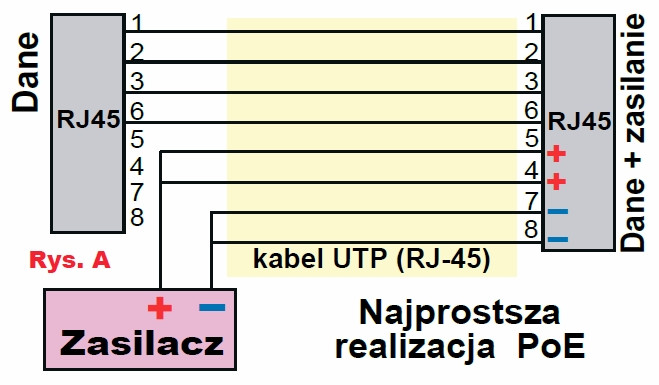

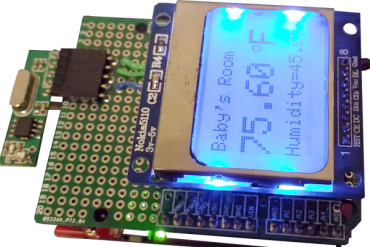

Po pierwsze nadal bardzo często skrót PoE (Power over Ethernet) dotyczy najprostszych rozwiązań, gdzie nie ma żadnego połączenia między liniami zasilania i liniami danych i gdzie nie ma też żadnej negocjacji. W najpopularniejszych obecnie wersjach Ethernetu (10/100 BaseT) wykorzystywane są dwie pary (cztery żyły) czteroparowej skrętki UTP, a dwie pary, czyli cztery pozostałe żyły są wolne i można je wykorzystać do zasilania. Przykład na rysunku A pochodzi z karty katalogowej pewnego adaptera PoE.

Mamy tu niewątpliwie PoE, czyli przekazywanie energii zasilania przez żyły kabla ethernetowego, ale nie ma to nic wspólnego ze standardem PoE 802.3, ponieważ wykorzystany może być dowolny zasilacz, np. o napieciu 12V czy 5V.

W standardzie PoE przewiduje się różne możliwości, także bardzo podobne jak na rysunku A, jednak standard 803.3 stawia szereg wymagań obwodom zasilania.

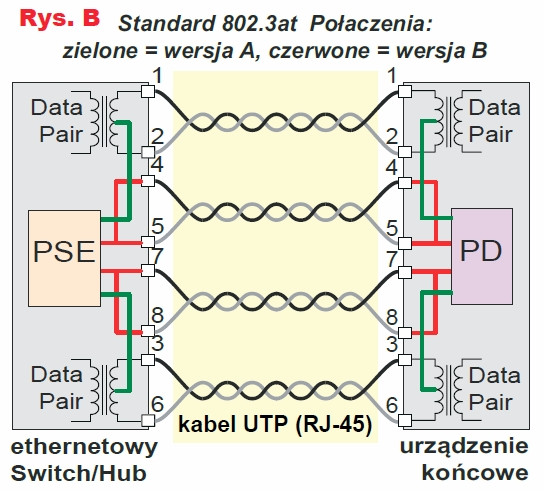

Na przykład w najprostszych zastosowaniach według rysunku A jeden duży zasilacz mógłby zasilać wiele urządzeń, które będą do niego bezpośrednio połączone równolegle. W standardzie 802.3 przewiduje się, że każdy kabel UTP będzie zasilany oddzielnie: z jednej strony kabla mają być umieszczone obwody zwane PSE (Power Sourcing Equipment) – rodzaj inteligentnego zasilacza, a w urządzeniu końcowym na drugim końcu kabla inteligentny obwód zasilający w odbiorniku, zwany PD (Powered Device) . Pokazuje to rysunek B.

Po co taka komplikacja?

Najprościej biorąc, zapobiega to poważnym problemom, na przykład podczas zwarcia lub przy nadmiernym poborze prądu, co mogłoby przegrzać izolację drutu w kablu UTP. W praktyce jeden duży zasilacz dostarcza energię do urządzeń dołączonych do wielu kabli UTP. Przy najprostszym połączeniu według rysunku A, zwarcie w jednym z kabli (zasilanych urządzeń) wyłączy ten jedyny główny zasilacz i uniemożliwi pracę wszystkich innych zasilanych przezeń urządzeń.

W systemie według 802.3 i rysunku B zwarcie jednej linii spowoduje reakcję tylko jednego współpracującego obwodu PSE i obwód ten po prostu odłączy zasilanie tylko tej jednej uszkodzonej linii. Potem będzie inteligentnie sprawdzał, czy zwarcie ustąpiło i czy dołączone jest prawidłowe obciążenie.

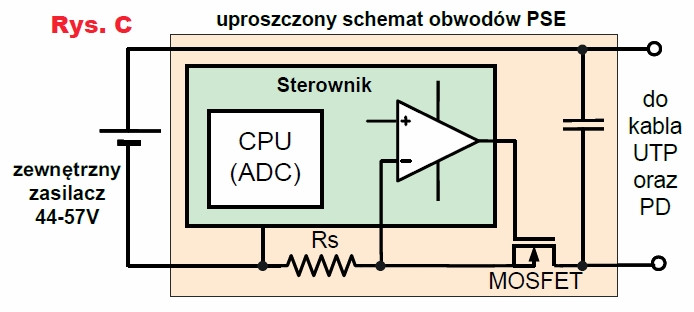

Obwód zasilający PSE musi więc być dość rozbudowany. Musi mieć obwód pomiaru prądu linii oraz wyłącznik lub ogranicznik prądu, co w uproszczeniu pokazane jest na rysunku C. Musi mieć też obwód płynnej regulacji napięcia wyjściowego od zera w niezbyt szybkim tempie.

System według standardu 802.3 ma być nie tylko odporny na zwarcia. Musi być znacznie bardziej inteligentny i bezpieczny. I tak zasilanie NIE ma być podawane na linię ciągle, a tylko wtedy, gdy na końcu linii zostanie wykryte obciążenie – urządzenie, ale nie jakiekolwiek, tylko spełniające wymagania standardu 802.3. Chodzi o to, żeby nie podać zbyt wysokiego napięcia na jakieś inne dołączone tam niestandardowe urządzenie starego typu, które mogłoby zostać uszkodzone zbyt wysokim napięciem zasilania.

Tu dochodzimy do kolejnej ważnej sprawy: niektóre zasilane urządzenia końcowe potrzebują stosunkowo dużej mocy zasilania. Przykładowo jeżeli urządzenie zasilane napięciem 5V zużywa 30 watów mocy, to potrzebny prąd zasilania musiałby wynosić 6 amperów. A takiego prądu na pewno nie można przesłać przez kabel UTP, którego żyły mają średnicę 0,5mm, czyli przekrój około 0,2mm2.

Owszem, tak dużą moc można przesłać, ale przy wyższym napięciu, na przykład 60V, co oznacza prąd 0,5A. Dlatego w standardzie 802.3 przewdziano pracę przy napięciu zasilającym co najmniej 44V. Jednak napięcie to nie może być zbyt wysokie ze względów bezpieczeństwa. W pierwszej wersji standardu (802.3af) przewidywano napiecie 44...57V i prąd maksymalny 350mA, co w najgorszym przypadku po uwzględnieniu strat gwarantowało 12,95W mocy do zasilania urządzenia końcowego. W grę wchodzi sprawność urządzeń PSE i przetwornicy obniżającej w obwodach PD oraz długość linii ethernetowej do 100m, a 2×100m drutu 0,5mm może mieć rezystancję do 20 omów.

W następnych wersjach standardu (np. PoE 802.3bt) przewidziano wykorzystanie do zasilania wszystkich 4 par kabla UTP, zwiększono maksymalny dopuszczalny prąd, co pozwala uzyskać do 51W, a nawet 60W mocy dla zasilanych urządzeń końcowych (do 100W pobieranych przez obwody PSE).

Powstaje kolejny problem: jeśli w jakiejś serwerowni byłoby na przykład 100 linii PoE, każda o mocy maksymalnej do 100W, to potrzebny byłby jakiś potężny zasilacz o napięciu nieco niższym od 60V i mocy 10 kilowatów! Jednak tylko niektóre urządzenia końcowe potrzebują mocy zasilania rzędu kilkudziesięciu watów – większości wystarczy kilka do kilkunastu watów. Aby zracjonalizować zapotrzebowanie na moc, od początku przewidziano podział urządzeń końcowych na klasy według mocy, która jest im potrzebna. I tu dochodzimy do kwestii negocjacji, o czym za chwilę.

Po pierwsze, inteligentny obwód PSE nie ma podawać napięcia na linię ethernetową ciągle, a jedynie wtedy, gdy wykryje, że z drugiej strony zostało dołączone urządzenie standardu 802.3. Aby to miało sens, musi też odłączyć napięcie, gdy pracujące urządzenie przestanie pobierać prąd (albo zostanie odłączone, albo samo sie wyłączy). W stanie spoczynku obwody PSU wykrywają obecność standardowego urządzenia dołączonego na końcu linii przez sprawdzanie, czy do linii dołączona jest rezystancja 25kΩ ± 1,25kΩ. Sprawdzanie to musi następować przy bezpiecznym, niskim napięciu, żeby nie uszkodzić ewentualnych urządzeń niestandardowych.

Przy niskich napięciach (stałych) obwody PD w urządzeniu końcowym muszą mieć rezystancję 25kΩ i to jest informacja, że do linii dołączone jest urządzenie standardu 802.3.

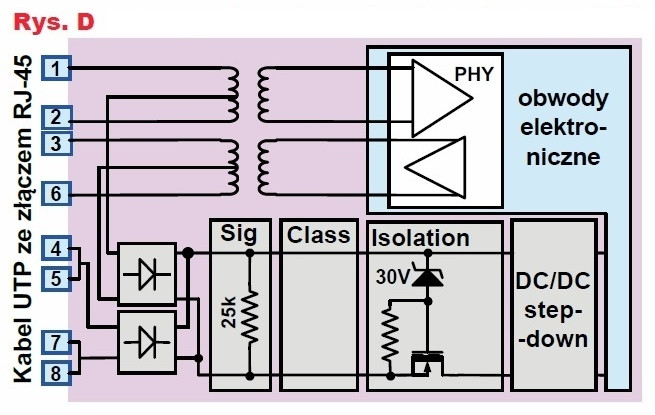

Dlatego po drugiej stronie linii zasilany obwód PD na pewno musi mieć przetwornicę obniżającą, ale też włączony na stałe rezystor 25kΩ oraz obwody kontrolno-sterujące potrzebne do negocjacji. Rysunek D pokazuje uproszczony schemat urządzenia końcowego standardu 802.3. Możliwe jest przekazywanie zasilania przez niewykorzystane żyły (4, 5, 7, 8) lub przez żyły wykorzystywane do przesyłania danych (1, 2, 3, 6).

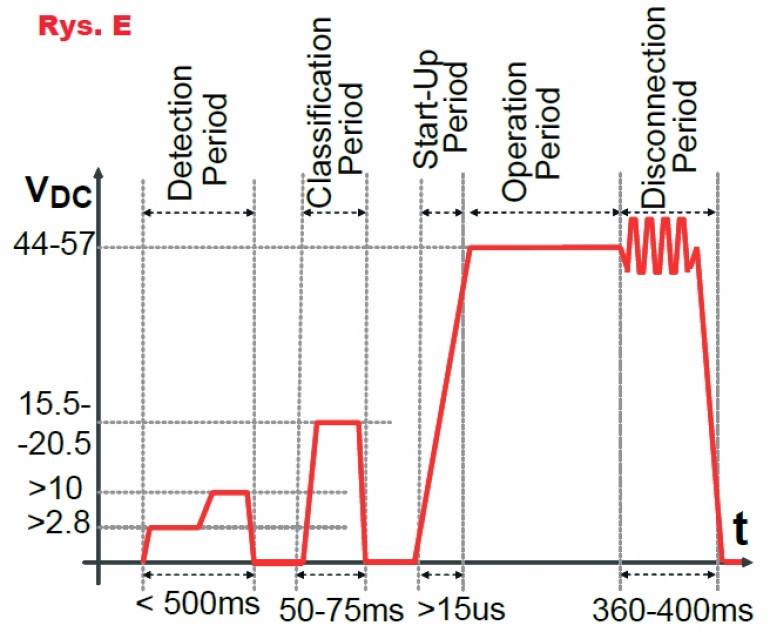

W obwodach zasilania umieszczone są dwa diodowe mostki prostownicze, a to oznacza, że przy małych napięciach na linii 0...1,4V prąd nie będzie tam płynął. Tymczasem detekcja, czy urządzenie końcowe spełnia wymagania standardu 802.3, polega na sprawdzeniu, czy przy małych, bezpiecznych napięciach ma ono rezystancję 25kΩ. Obecność mostków diodowych zniekształciłaby wynik najprostszego pomiaru (R = U/I), dlatego rezystancja 25kΩ mierzona jest metoda przyrostową. Pokazuje to rysunek E, przedstawiający przebiegi podczas detekcji i negocjacji.

Otóż urządzenie PSE w fazie detekcji podaje na linię najpierw napięcie (U1) nieco wyższe niż 2,8V i mierzy prąd (I1). Potem podwyższa napięcie do wartości nieco ponad 10V (U2) i znów mierzy prąd (I2). Trwa to mniej niż pół sekundy. Urządzenie PSE oblicza rezystancję jako stosunek różnicy napięć i prądów: R = ΔU / ΔI = (U2 – U1) / (I2 – I1)

Jeżeli rezystancja nie jest równa 25kΩ ±5%, wtedy PSU stwierdza, że na końcu linii nie ma urządzenia PD standardu 802.3 i nie podaje na linię napięcia. Ale jeżeli zmierzona rezystancja jest prawidłowa, następuje faza klasyfikacji. Warto dodać, że w fazie detekcji urządzenie PD w ogóle nie pracuje i nie jest zasilane – mierzona jest tylko wartość rezystora, włączonego na wejściu, zaraz za mostkami.

Ale urządzenie PD musi być tak zbudowane, że dalsze zwiększanie napięcia do co najmniej 15V spowoduje albo pracę całego tego urządzenia, albo częściej tylko obwodów klasyfikacji. W fazie klasyfikacji urządzenie PSU podaje na linię napięcie 15,5V...20,5V, urządzenie PD wykrywa to napięcie i traktuje je jako zapytanie o to, ile mocy potrzebuje dane urządzenie PD.

PD odpowiada, ustalając określoną wartość prądu w linii. Nie jest do tego niezbedny mikroprocesor. Jak sugeruje rysunek D, napięcie klasyfikacji nie większe niż 20,5V nie powoduje jeszcze włączenia całej elektroniki w urządzeniu PD. Klasyfikację, czyli ustalenie wartości prądu w linii przy napięciu 15,5V...20,5V, może zrealizować jakiś prosty analogowy układ źródła prądowego.

W tym czasie urządzenie PSU mierzy ten prąd i z jego wartości dowiaduje się, jakie jest maksymalne zapotrzebowanie tego urządzenia końcowego na moc zasilania. Podkreślmy, że wtedy w linii nie płynie finalny prąd zasilania (bo elektronika jest jeszcze wyłączona), tylko prąd w linii ma wartość określająca klasę zapotrzebowania na moc. Stosowne informacje zawiera powyższa tabela 1. Jeżeli przy napięciu linii prąd nie przekracza wartości 5mA, to znaczy, że urządzenie PD nie ma zaimplementowanych obwodów klasyfikacji mocy i według pierwotnej specyfikacji 802.3 pobór mocy może sięgnąć 13W. Ale jeżeli prąd klasyfikacji wynosi 16mA ... 21ma, to urządzenie PD pobierze z obwodu zasilania maksymalnie 3,84W...6,49W mocy.

Klasy mocy oznaczone 0...4 zdefiniowane były już w pierwszej wersji standardu, czyli IEEE 802.3af z roku 2003. Od początku wadą była stosunkowo mała moc maksymalna dostarczana do urządzeń końcowych (niecałe 13W). W roku 2009 wprowadzono „mocniejszą” wersję standardu IEEE 802.3at-2009, oznaczaną często PoE+ z mocą maksymalną około 51W, gdzie większą moc można przesłać m.in. dzięki wykorzystaniu wszystkich czterech par skrętki UTP.

Natomiast klasy mocy 7, 8 (do 100W) dotyczą urządzeń nowszego standardu 802.3bt z roku 2018. Na marginesie warto przypomnieć, że nowa wersja standardu (802.3bt) ukazała się stosunkowo późno, a już wcześniej niektóre wiodące firmy zaoferowały układy scalone sterowników PSE i PD nie tylko do 13-watowego standardu 802.3af i 51-watowego PoE+, ale też pokrewne własne rozwiązania o mocach nawet ponad 100W.

W każdym razie urządzenie PSU w trwającej 50...75ms fazie klasyfikacji dowiaduje się o zapotrzebowaniu mocy i może tę informację wysłać do procesora zarządzającego zasilaniem całego systemu, żeby optymalizować zasoby. Gdyby na przykład później to urządzenie chciało pobrać więcej mocy – oznacza to, że nastąpiła jakaś awaria.

Dopiero po detekcji i klasyfikacji następuje podanie na linię właściwego napięcia zasilającego o wartości 44V ... 57V. Jak wskazuje rysunek E, nie następuje to gwałtownie, tylko napięcie zasilające narasta płynnie w ciągu co najmniej 15us. I jak wskazuje obecność diody Zenera (30V) na rysunku D, dopiero wtedy włączana jest przetwornica obniżająca DC/DC i dopiero wtedy zaczyna pracować cała elektronika w urządzeniu końcowym. I dopiero wtedy możliwe jest przekazywanie danych cyfrowych przez łącze ethernetowe.

Można tu dodać, że po wstępnej analogowej klasyfikacji i negocjacji, precyzyjny przydział mocy dla PD z dokładnością do 0,1W może nastąpić po wymianie cyfrowych informacji z wykorzystaniem protokołu LLDP (albo CDP). Protokół LLDP (IEEE 802.1AB i IEEE 802.3-2012 sekcja 6 klauzula 79) został zasadniczo opracowany do innych celów, do określenia aktualnej budowy sieci, ale pozwala też przesyłać informacje o zapotrzebowaniu na moc.

W standardzie PoE 802.3 jest też określone, że jeżeli urządzenie końcowe (PD) przestanie pobierać energię (prąd zasilania zmniejszy się poniżej 7,5mA (5mA...10mA), wtedy urządzenie PSE musi wyłączyć napięcie zasilające. Gdy urządzenie standardu 802.3 zostanie odłączone, później mogłoby tam zostać dołączone inne urządzenie, albo standardu 802.3 o innym zapotrzebowaniu na moc, albo co gorsze, niestandardowe, w którym podanie wysokiego napięcia do 57V spowodowałoby jakieś uszkodzenia. Dlatego wymagane jest odłączenie napięcia po zmniejszeniu poboru prądu poniżej 5mA...10mA.

Wracamy do pytań zadanych przez Czytelnika: po pierwsze podczas negocjacji, czyli w fazie analogowej detekcji i klasyfikacji NIE następuje wymiana danych cyfrowych. Elektronika urządzenia końcowego nie jest wtedy jeszcze zasilana. Negocjacja jest wymianą informacji, ale nie danych cyfrowych, tylko przeprowadzana jest w sposób analogowy.

Po drugie ma to związek z zakłóceniami. Otóż standard 802.3 określa, że opisywane zmiany napięć i prądów nie mogą następować gwałtownie. Zgodnie z ustaleniami Fouriera, ostre zbocza oznaczają pojawienie się w linii sygnałów o wysokiej częstotliwości, w praktyce silnych kilkudziesięciowoltowych i co najmniej kilkudziesieciomiliamperowych impulsów szpilkowych. Różnymi drogami mogłyby one zakłócać przesyłanie danych ethernetowych, w tym przenikać do innych kabli. Jeżeli zbocza impulsów zasilania będą łagodne, takiego zakłócania nie będzie.

Czytelnik pytał: w jaki sposób zasilanie DC jest puszczane razem z danymi tymi samymi przewodami?

Nie ma żadnego problemu przy użyciu dwóch niewykorzystanych żył kabla UTP, co przewidziano w standardzie 802.3af jako wersję B. Wtedy połączenia są takie, jak pokazują na rysunku B linie czerwone (a połączeń według linii zielonych nie ma). Ale już w pierwotnym standardzie przewidziano też wersję A z połączeniami pokazanymi przez linie zielone. Tam też nie ma żadnego problemu ze współistnieniem w jednej żyle impulsowych sygnałów ethernetowych i przebiegów zasilających.

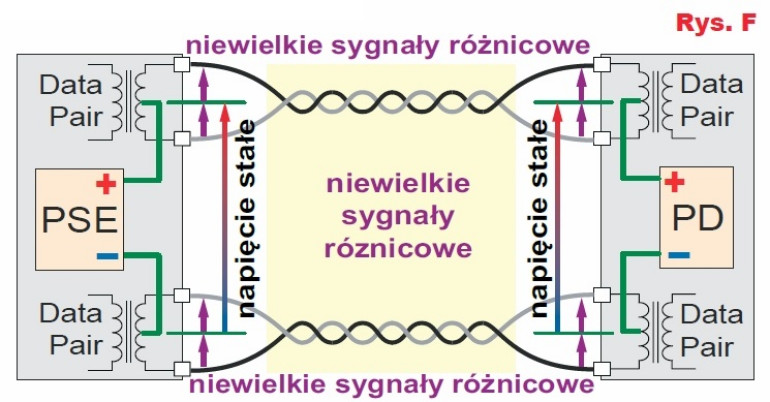

Tylko w pierwszych sieciach LAN wykorzystywano kable współosiowe, natomiast standard PoE 802.3 dotyczy skrętki czteroparowej (UTP i pokrewnych). A w takich skrętkach dane są przesłane za pomocą impulsów o amplitudzie rzędu pojedynczych woltów. Co bardzo ważne, zawsze są przesyłane symetrycznie. W tych systemach symetrycznych nie ma linii masy, tylko dwie żyły „gorące”, a odbiornik reaguje na sygnał różnicowy. Tym bardziej że wymagania „ethernetowe” wymuszają zastosowanie transformatorków izolacyjnych, które zapewniają oddzielenie galwaniczne między każdym urządzeniem a linią i to na obu stronach łącza ethernetowego, co jest pokazane na rysunkach B, D.

Gdyby łącze ethernetowe miało linię masy, byłby problem z PoE. Jednak dzięki zastosowaniu transformatorków zapewniających izolację galwaniczną możliwe są różne wersje PoE, między innymi pokazana na rysunku F wersja A standardu 802.3af, gdzie plus i minus napięcia zasilania przekazywane są przez dwie pary skrętki UTP.

Między żyłami skrętki występują impulsy danych. W 10-begabitowej wersji 10BASE-T nadajnik wysyła impulsy o amplitudach +2,5V i −2,5V. W najpopularniejszej obecnie wersji Ethernetu 100BASE-TX sygnały z nadajnika mogą mieć amplitudę: +1V, 0V lub −1V. W gigabitowym Ethernecie 1000BASE-T wykorzystuje się wszystkie cztery pary skrętki, a impulsy z modulatora 4D-PAM5 mogą mieć amplitudy −2V, −1V, 0 V, +1V, +2V. Zawsze jednak są to impulsy symetryczne, więc średnie napięcie między żyłami danej pary jest równe zeru, więc nie ma znaczenia, jaki jest potencjał wspólny tych dwóch żył.

Patrząc z innej strony, można powiedzieć, że w dwóch żyłach skrętki współistnieją impulsy danych, których widmo to sygnały o dużej częstotliwości oraz napięcie i prąd stały, czyli sygnały o częstotliwości równej zeru. Są one w naturalny sposób odseparowane, bo transformatory nie przenoszą sygnałów o częstotliwości zero i sygnałów o małych częstotliwościach. I właśnie zbocza impulsów napięcia i prądu związanych z PoE muszą być łagodne, żeby nie zawierały składowych o wysokiej częstotliwości, leżącej w zakresie widma impulsów danych.

Dla Autora pytania intrygujące jest to, jak zasilanie współistnieje z przesyłanymi danymi. Najprostsza odpowiedź jest taka: zasilanie dotyczy prądu stałego i składowych małej częstotliwości podczas powolnych zmian napięć i prądów, natomiast dane są transmitowane z wykorzystaniem dużo wyższych częstotliwości, nawet wielu megaherców.

Współistnienie jest możliwe i łatwe dzięki temu, że sieciowy standard Ethernet wymaga obecności transformatorków separujących na dwukierunkowych wyjściach/wejściach. I to w sumie te malutkie transformatorki impulsowe z odczepem w środku izolują galwanicznie tor przesyłania informacji od żył linii, co umożliwia zasilanie prądem stałym przez dwie albo wszystkie cztery pary skrętki UTP.