Niniejszy artykuł to pobieżny przegląd obecnie dostępnych technologii asystujących i wspierających dla osób z niepełnosprawnością oraz spojrzenie na przyszłość tego segmentu rynku. Spora część tego artykułu poświęcona będzie narządowi wzroku, z kilku względów.

Według szacunków naukowców wzrok dostarcza 70...80% wszystkich informacji zmysłowych człowieka, co czyni go najważniejszym zmysłem człowieka. Jego utrata, szczególnie nagła, jest doświadczeniem często traumatycznym. Po drugie, problemy ze wzrokiem dominują wśród niepełnosprawności. Według danych Światowej Organizacji Zdrowia (WHO), co najmniej 2,2 miliarda ludzi na świecie ma zaburzenia widzenia lub ślepotę. W Polsce żyje około 1,75 miliona osób z niepełnosprawnością narządu wzroku. Po trzecie, niepełnosprawność wzroku jest tym problemem, który Autor zna z doświadczenia, a co za tym idzie, posiada najwięcej wiedzy właśnie ten temat.

Wszystkie fotografie pochodzą z materiałów reklamowych producentów, chyba że zaznaczono inaczej.

Mobilność dla niedowidzących i niewidomych

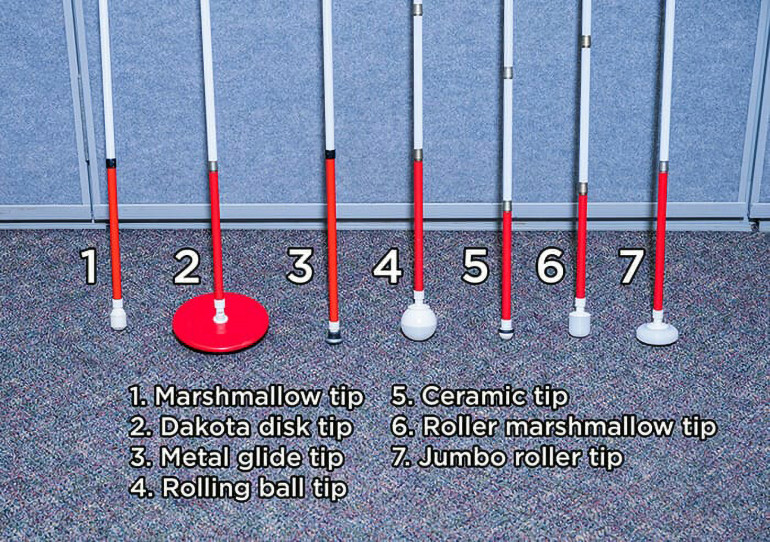

Biała laska jest de facto symbolem osób niewidomych, ale nie tylko one z niej korzystają. Również osoby słabowidzące posługują się tym narzędziem, szczególnie gdy warunki nie sprzyjają percepcji, lub gdy wada wzroku istotnie ogranicza percepcję potencjalnych przeszkód. Biała laska nie jest wynalazkiem nowym – ludzie używali kijów różnej długości jako probierzy terenu już w czasach antycznych. Jednakże pierwszym prawdziwym użytkownikiem białej laski został James Biggs, angielski fotograf, który w 1921 roku stracił wzrok w wyniku wypadku. To on jako pierwszy pomalował zwykłą laskę na biało, by być lepiej widocznym dla użytkowników dróg. Od tamtej pory biała laska zmieniła się w niewielkim stopniu. Podstawowa konstrukcja wykonana jest z aluminium lub grafitu (czasem też włókna szklanego) i składa się z kilku segmentów – przebiegająca przez wnętrze elastyczna linka trzyma segmenty razem i pozwala na składanie laski. Obecnie laski te występują w innych kolorach niż biały, zwykle z pierwszym segmentem w kolorze czerwonym (często odblaskowym). Końcówka laski, czyli część dotykająca gruntu, występuje w kilku wariantach, zależnie od preferencji użytkownika. Dwa podstawowe typy to zwykły, zaokrąglony walec oraz podobny walec z łożyskami wewnątrz, pozwalający na swobodne toczenie się po gruncie. Te i inne końcówki pokazuje fotografia 1.

Od lat trwają prace nad „ulepszeniem” białej laski za pomocą elektroniki, większość z nich stanowi jednak rozwiązania mało przydatne i/lub wymagające zaawansowanego treningu, oferując przy tym niewielkie korzyści. Opracowano więc opaski czołowe, pasy i kamizelki wyposażone w dalmierze ultradźwiękowe, podczerwone lub LIDAR-y, które mają dostarczyć większej informacji o najbliższym otoczeniu i ostrzegać dźwiękiem lub wibracjami przed przeszkodami znajdującymi się poza zasięgiem samej laski. Większość z nich jednak w praktyce nie sprawdza się wcale, dając za dużo (a przy tym często sprzecznych) komunikatów. Spora część tych rozwiązań ma formę niedopracowanych prototypów, przez co nie wyglądają też estetycznie. Projekty te zwykle zostają porzucone zaraz po konkursie, na który zostały opracowane. Wyjątkiem jest jeden dopracowany produkt, WeWALK Smart Cane 2, czyli biała laska z asystentem głosowym opartym na GPT oraz funkcją detekcją przeszkód na wysokości głowy użytkownika. Laska do działania wymaga smartfona ze stałym dostępem do Internetu i większość jej możliwości wynika tylko i wyłącznie z oprogramowania, z którym współpracuje, szczególnie zaś z systemu SI opartego na dużym modelu językowym (LLM). Smart Cane 2 poza asystentem głosowym oferuje też wsparcie nawigacyjne: nawigację krok po kroku do konkretnego celu oraz informację o mijanych miejscach (sklepy, restauracje, budynki użyteczności publicznej, etc.), system ostrzegawczy zaś zapewnia informację zwrotną za pomocą dźwięku i sygnalizacji haptycznej. Urządzenie prezentuje fotografia 2, pochodząca ze strony producenta.

Czytelnika może też zaciekawić recenzja/demonstracja tej laski z kanału YouTube o nazwie The Blind Life: https://youtu.be/cIVoECPglSo.

Innym „narzędziem” nawigacji i orientacji w terenie jest pies-przewodnik. Wbrew powszechnemu mniemaniu zadaniem psa wytresowanego do roli przewodnika nie jest prowadzenie osoby niewidomej lub słabowidzącej, lecz omijanie przeszkód i unikanie potencjalnych wypadków. Co ważne, nawet najlepiej wyszkolony pies popełnia czasami błędy i choć ułatwia poruszanie się w przestrzeni publicznej, to nie stanowi stuprocentowej gwarancji bezpieczeństwa. Warto też wspomnieć, że nie każdy pies nadaje się na przewodnika, a do tego tylko połowa wyselekcjonowanych psów z powodzeniem kończy szkolenie. Dlatego też dostęp do psa-przewodnika w Polsce jest ograniczony, a samo szkolenie do tanich nie należy. Jak łatwo się domyślić, technologia nie jest w stanie zastąpić naturalnej inteligencji i percepcji wyszkolonego zwierzęcia, choć takie próby są podejmowane. Czy roboty w rodzaju Spota firmy Boston Dynamics (fotorafia 3) mają szansę zastąpić żywego psa?

Z pewnością mają dostateczną percepcję zmysłową i zdolności nawigacyjne. Problemem jednak jest stworzenie odpowiedniego oprogramowania oraz koszt samego robota. Spot w wersji podstawowej, bez czujników, specjalizowanego oprogramowania i innych elementów, kosztuje 75 tysięcy dolarów. Drugim problemem, który zaobserwował student Queensland University of Technology, pracujący nad zastosowaniem robota w roli przewodnika, jest zbyt duża sztywność „grzbietu” – Spot porusza się sprawnie w jednym kierunku, ale skręcanie jest dla niego trudne. Chińska firma Unitree też oferuje roboty-psy w znacząco niższej cenie: model Go1 kosztuje od 2700 dolarów, Go2 zaś zaś od 1600 dolarów. Co ciekawe, Go1 też był używany jako pies-przewodnik. Przyszłość zapowiada się zatem ciekawie. Go2 Air jest dostępny w Polsce już od około 13 700 złotych, czyli za dwa razy więcej, niż wynosi cena producenta.

Percepcja otoczenia to niejedyny aspekt nawigacji dla osoby niedowidzącej czy niewidomej. Ważne jest też, by znać swoją bieżącą lokalizację oraz lokalizację celu. W przeszłości poruszając się z pomocą laski i psa-przewodnika, trzeba było zachować w pamięci mentalną mapę otoczenia. O ile każdy człowiek tworzy taki obraz w swojej głowie dla dobrze mu znanej lokalizacji, jak własne mieszkanie/dom, to tworzenie takiej mapy dla nawet niedużego wycinka przestrzeni publicznej stanowi już wyzwanie. Istnieją jednak dwa narzędzia, które obecnie mocno ułatwiają taką nawigację i oba dostępne są dla każdego. Pierwszy to nawigacja satelitarna. Już 25 lat temu eksperymentowano z urządzeniami GPS, które zamiast tradycyjnego wyświetlacza miały małą matrycę brajlowską, na której wyświetlana była konturowa mapa, którą posługiwać się mogła osoba niewidoma. Obecnie jednak stosuje się nawigację głosową opartą zarówno o gotowe rozwiązania w rodzaju Google Maps, jak i własne koncepcje, jak choćby ViaOpta Nav. Dokładność takiej nawigacji zależy od warunków oraz systemu satelitarnego, który jest używany i może wynosić od jednego metra do kilkunastu metrów. Warto nadmienić, że da się zastosować różne triki, by zwiększyć dokładność nawigacji, zwłaszcza w mniej korzystnych warunkach. Nawigacja taka jednak nie za bardzo sprawdza się wewnątrz budynków i na razie nie ma jednego, uniwersalnego rozwiązania tego problemu, choć opracowano cały szereg różnych rozwiązań, głównie z myślą o robotach mobilnych. Dostępne układy IMU oraz możliwości łączności bezprzewodowej pozwalają na stworzenie hybrydowego systemu nawigacji budynkowej, w którym poszczególne pomieszczenia i piętra mają własne nadajniki radiowe, przekazujące informację o lokalizacji, zaś urządzenie odbiorcze wspiera nawigację, używając inercyjnego pomiaru prędkości i położenia.

Drugim aspektem nawigacji jest zdolność do identyfikacji lokalizacji i elementów otoczenia. Dla osoby niedowidzącej od lat dostępne są narzędzia optyczne, jak monookulary pozwalające czytać napisy na budynkach, znaki i światła drogowe, numery autobusów czy tablice informacyjne na i wewnątrz autobusów, autokarów i pociągów. Jednak gdy wada wzroku staje się zbyt głęboka, pomoc optyczna przestaje wystarczać. Pewnym rozwiązaniem pośrednim przez ostatnie 15...20 lat były aparaty wbudowane w smartfony – szczególnie w ostatniej dekadzie, gdy producenci starali się upychać matryce o coraz większej rozdzielczości. Aparat taki pozwala na zrobienie zdjęcia i znaczne powiększenie obrazu, co ułatwia odczytanie znaków, tablic czy choćby cen w sklepie. Jednak obecnie lepszym wyborem są aplikacje w rodzaju Google Lens czy Microsoft Seeing AI, które dysponują funkcją OCR (optycznego rozpoznawania tekstu). Szczególnie ta druga aplikacja, dedykowana osobom niedowidzącym i niewidomym, jest użyteczna. Poza możliwością szybkiego odczytania krótkich tekstów, jak tabliczki i etykiety, umożliwia też czytanie całej strony, przy czym program podpowiada, jak ustawić telefon względem kartki, by zeskanować cały tekst. Kolejną funkcją jest skanowanie otoczenia i identyfikowanie obiektów, co jest realizowane za pomocą dedykowanego modelu AI Microsoftu. Aplikacja ma też skaner kodów kreskowych produktów, skaner pieniędzy, miernik jasności i identyfikator kolorów. Ciekawą funkcją jest też mechanizm opisujący płeć i wiek osoby, na którą skierujemy obiektyw. Zaletą Seeing AI jest fakt, że aplikacja pozostaje kompletnie darmowa. Alternatywę stanowią dwie inne aplikacje: BeMyEyes i Aira. Programy te różnią się od Seeing AI tym, że nie używają one sztucznej inteligencji. Zamiast tego obraz ze smartfona przekazywany jest do wolontariusza, który komunikuje się z użytkownikiem i pomaga mu w identyfikacji i nawigacji. W przypadku Aira dodatkowo osoba udzielająca pomocy przechodzi szkolenie, dzięki czemu jest bardziej pomocna niż zwykły wolontariusz. BeMyEyes wspiera wiele różnych języków, ale Aira jest dostępna tylko dla użytkowników anglojęzycznych.

Używanie smartfona przez cały czas może być niewygodne, a nawet wręcz niebezpieczne, dlatego istnieją alternatywy. Okulary Envision Glasses (fotografia 4) pozwalają na korzystanie z tych samych funkcji, co Seeing AI, plus dodają kilka kolejnych udogodnień.

Dla przykładu: funkcja „Find Object” pozwala wybrać jeden obiekt z dość bogatej listy, okulary skanują otoczenie wizualnie w poszukiwaniu tego obiektu i po jego zlokalizowaniu podają kierunek, w którym się on znajduje. Pozwala to na przykład zlokalizować ławki, krzesła, drzwi, światła drogowe i wiele innych obiektów. Okulary pozwalają też na nawiązanie połączenia video z drugą osobą i przesyłanie obrazu na żywo celem uzyskania pomocy. Współpracują również z usługą Aira, choć ta jest dostępna tylko po angielsku. Od niedawna dostępna jest także darmowa aplikacja Envision AI, która udostępnia wszystkie funkcje okularów w smartfonie. Podobnie jak w przypadku innych aplikacji, dostępne są wersje zarówno na system iOS, jak i Android. W ostatnich miesiącach jednak dużą popularność zyskały inne okulary: Meta Ray-Ban Smart Glasses (fotografia 5).

Te okulary są produkowane przez firmę Ray-Ban we współpracy z koncernem Meta, do którego należy m.in. Facebook. Okulary używają systemu sztucznej inteligencji Meta AI i choć nie są zaprojektowane specyficznie dla osób niedowidzących i niewidomych, to oferują wiele przydatnych im funkcji, a do tego są relatywnie tanie. Envision Glasses kosztują u polskiego dystrybutora sprzętu dla niepełnosprawnych około 9200 zł, podczas gdy Meta Ray-Ban Smart Glasses można nabyć za cenę między 1300 zł a 1800 zł, zależnie od wybranych szkieł.